La veille d'info anti fake-news et anti fatigue informationnelle !

Reçois ta newsletter intelligente, créée sur mesure pour toi

grâce à un savant mélange d’intelligence artificielle et collective.

👉 Gagne un temps précieux en ne recevant que les infos qui comptent pour toi.

👉 Découvre de nouvelles sources d'informations et perspectives.

👉 Partage des informations de qualité et inspire les autres.

Ils parlent de Flint

Flint a été adopté par plus de 20000 curieux et innovateurs.

Pour les curieux

qui veulent mieux comprendre le monde et découvrir de nouvelles sources d’information

Pour les pros

qui veulent découvrir des contenus originaux et partager de nouvelles idées

Pour les innovateurs

qui veulent mieux comprendre les évolutions rapides d’un marché et repérer les signaux faibles

Paroles d'explorateurs et utilisateurs

Flint alimente ma connaissance et ma réflexion sur des sujets clés que j'essaie ensuite d'utiliser dans mon travail ou mes discussions.

Flint m'aide à prendre du recul sur l'actualité. Il m'aide à comprendre le monde sans maltraiter mon cerveau. Il m'a été très utile pour mieux traverser la crise du Covid-19.

Flint me permet d'apprendre des choses nouvelles, et à découvrir des sources introuvables sans être expert du domaine.

Flint m’a aidé à comprendre certaines actualités en étant sûre des sources et en gagnant du temps.

Notre méthode pour t'apporter le meilleur

Fouiller l'immensité du web pour toi

Trier pour ne conserver que de la qualité

Ajouter un soupçon de découverte et d'exploration

Analyser l'info pour mieux la comprendre

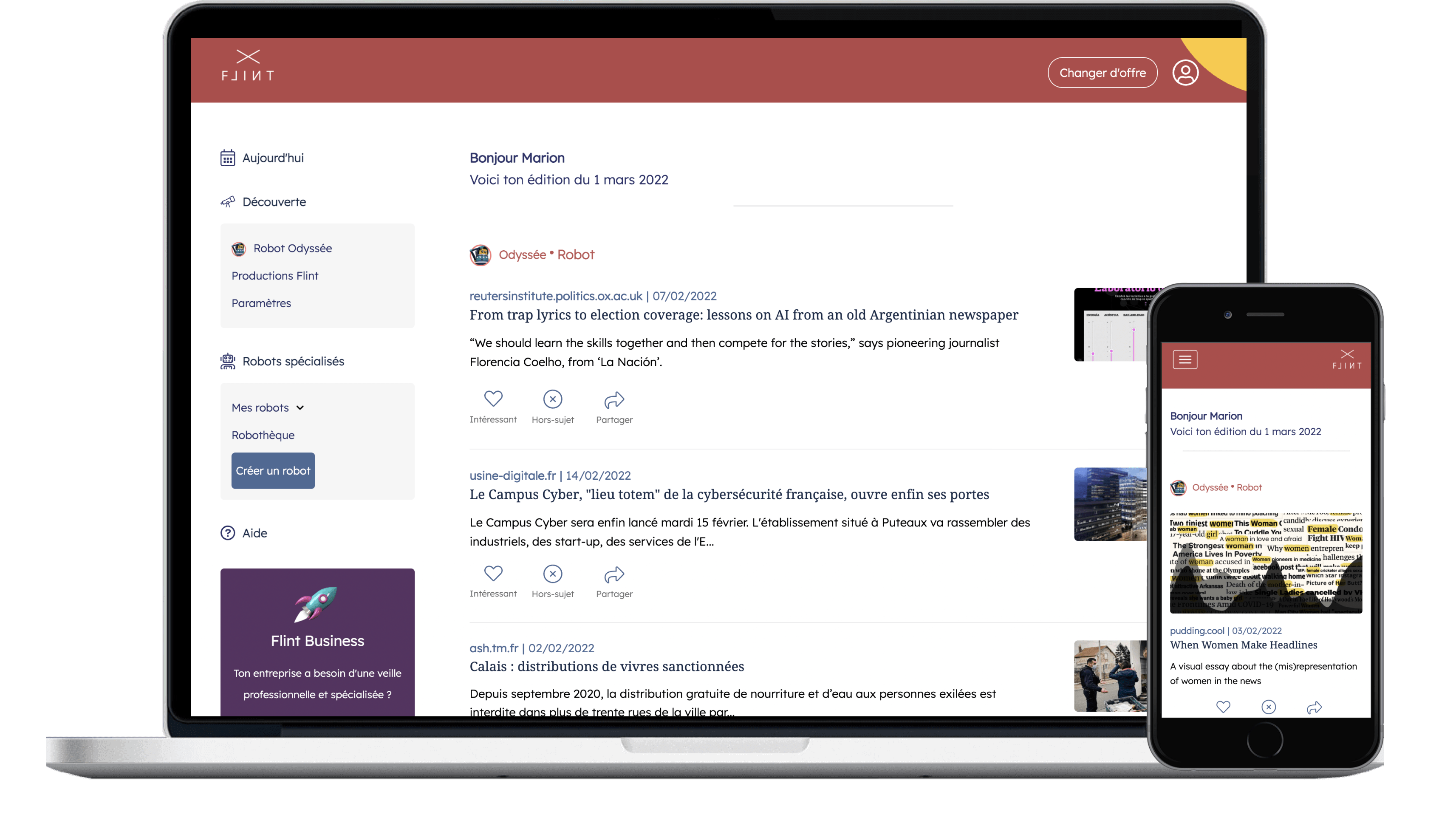

Comment ça marche ?

Nous trouvons les meilleures infos pour toi en associant 5 éléments :

1 - Nos algorithmes analysent le comportement d’un panel de 22.000 experts sur plusieurs millions de contenus d’information.

2 - L’intelligence artificielle ne sélectionne que le meilleur, éloigne le bruit et te protège des fausses nouvelles.

3 - Tu peux interagir avec ton robot pour améliorer sa sélection.

4 - Flint c’est aussi communauté active, avec des événements, une plateforme d’échange et de co-construction.

Besoin de créer des newsletters intelligentes

pour ton entreprise ?

Flint Business permet de repérer les contenus qui comptent vraiment et de les partager avec ses collaborateurs ou ses clients.

👉 Compose ta newsletter en quelques minutes en définissant les rubriques qui t’intéressent.

👉 Les robots remplissent la newsletter automatiquement en sélectionnant chaque semaine les contenus d’information qui comptent, et en privilégiant la diversité et la qualité des sources d’information.

👉 Il ne reste plus qu’à inviter tes collaborateurs ou tes clients à s’abonner à ta newsletter intelligente, aux couleurs de ton entreprise.